A infraestrutura termodinâmica da era digital enfrenta um teste de carga sem precedentes. Em dezembro de 2025, o cenário é claro: a Inteligência Artificial deixou de ser apenas um software revolucionário para se tornar um titã industrial faminto por eletricidade. O consumo de energia dos Data Centers não está apenas crescendo; ele está mudando a geografia energética do planeta, forçando a reabertura de usinas nucleares desativadas e desafiando as redes de distribuição elétrica das maiores economias do mundo.

Enquanto o mundo se maravilhava com a capacidade gerativa dos modelos de linguagem, os bastidores da engenharia enfrentavam uma realidade física brutal. A Agência Internacional de Energia (AIE) confirmou o que muitos temiam: o consumo global dessas estruturas está a caminho de ultrapassar 1.000 TWh até 2026 — um volume comparável a todo o consumo elétrico do Japão. Não se trata mais apenas de “treinar” modelos; a fase de inferência (o uso diário da IA por bilhões de usuários) transformou o pico de demanda em uma constante ininterrupta.

O Salto Termodinâmico: De Nuvem a Fornalha

A mudança fundamental reside na densidade. Um rack de servidores convencional, dedicado à nuvem tradicional, consumia entre 5 a 10 kW. Hoje, racks equipados com as mais recentes GPUs (como a arquitetura Blackwell da NVIDIA e sucessoras) operam frequentemente acima de 100 kW. Este aumento de 10 vezes na densidade de potência obriga uma reengenharia total do consumo de energia dos Data Centers.

🗞️ Artigos Relacionados:

Relatórios de setembro de 2025 do Goldman Sachs indicam que a demanda de energia impulsionada pela IA crescerá 160% até o final da década. O gargalo, contudo, deixou de ser a produção de chips e passou a ser a disponibilidade de transformadores e linhas de transmissão. A rede elétrica atual não foi desenhada para suportar “cidades digitais” que consomem, sozinhas, o equivalente a milhões de residências.

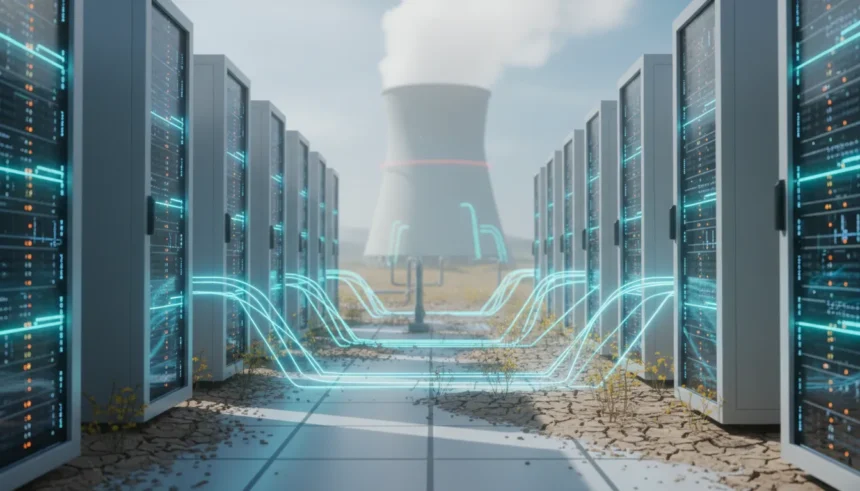

A Renascença Nuclear: Big Tech vira Big Energy

Diante da instabilidade das energias renováveis intermitentes (solar e eólica) para suprir uma demanda de base constante (24/7), as gigantes da tecnologia optaram por uma solução controversa, porém pragmática: a energia nuclear.

O acordo histórico entre a Microsoft e a Constellation Energy para reativar a Unidade 1 de Three Mile Island simboliza essa nova era. Pela primeira vez, uma usina nuclear desativada retorna à operação exclusivamente para alimentar a fome de dados de uma única corporação. O Google e a Amazon seguiram caminhos similares, investindo bilhões em Reatores Modulares Pequenos (SMRs) e fusões com produtores de energia locais. O objetivo é claro: desvincular o consumo de energia dos Data Centers da rede pública sobrecarregada, garantindo autonomia e “energia limpa” firme.

A Pegada Hídrica: O Custo Invisível da Refrigeração

Enquanto a eletricidade domina as manchetes, a água permanece como o custo oculto da IA. A transição para a refrigeração líquida — necessária porque o ar já não é suficiente para resfriar os chips modernos — alterou a dinâmica ambiental. Estima-se que uma conversa simples de 20 a 50 perguntas com um modelo de linguagem avançado “beba” o equivalente a uma garrafa de 500ml de água, evaporada nas torres de resfriamento para dissipar o calor gerado.

Em regiões com estresse hídrico, como partes do oeste americano e zonas da Europa, a expansão física dos data centers enfrenta agora resistência legislativa, não apenas pelo uso da rede elétrica, mas pela competição com o abastecimento de água urbano e agrícola.

O Paradoxo da Inferência e o Futuro

A narrativa de 2025 foca na “Inferência”. Se antes o treinamento do GPT-4 ou Gemini consumia gigawatts-hora uma única vez, hoje, cada e-mail resumido, cada imagem gerada e cada linha de código completada pela IA soma-se a uma conta energética perpétua. O consumo de energia dos Data Centers migrou de um custo de investimento (CapEx) para um custo operacional (OpEx) massivo e crescente.

A solução a longo prazo pode não estar apenas em mais energia, mas em algoritmos mais frugais. A indústria começa a valorizar modelos “pequenos” (SLMs) que rodam localmente em dispositivos (Edge AI), tirando a carga dos grandes centros de dados. Até lá, a simbiose entre silício e urânio parece ser o único caminho para manter as luzes da inteligência artificial acesas.

LEIA TAMBÉM: O que são SMRs e o futuro da energia nuclear

FAQ (Perguntas Frequentes)

Q: A IA vai colapsar a rede elétrica mundial? A: É improvável um colapso global, mas gargalos regionais severos já são realidade. Em locais como a Virgínia (EUA) e Irlanda, novas conexões de data centers estão sendo pausadas ou racionadas devido à falta de capacidade de transmissão.

Q: Por que a energia solar e eólica não são suficientes para Data Centers de IA? A: Data Centers de IA operam 24 horas por dia com carga quase constante. Solar e eólica são intermitentes (dependem de sol e vento). Sem baterias de escala industrial massiva (ainda inviáveis economicamente para essa escala), é necessária uma fonte de “energia de base” firme, como nuclear ou gás natural.

Q: Qual é a diferença entre o consumo de “treinamento” e “inferência”? A: O treinamento é o processo de “ensinar” a IA, que consome uma quantidade massiva de energia por alguns meses. A inferência é o uso da IA já pronta pelos usuários. Em 2025, a inferência já representa cerca de 80-90% do consumo total de energia da IA, pois ocorre continuamente em escala global.

🤔 Faltou alguma coisa?

Ajude-nos a melhorar este conteúdo com a sua sugestão.